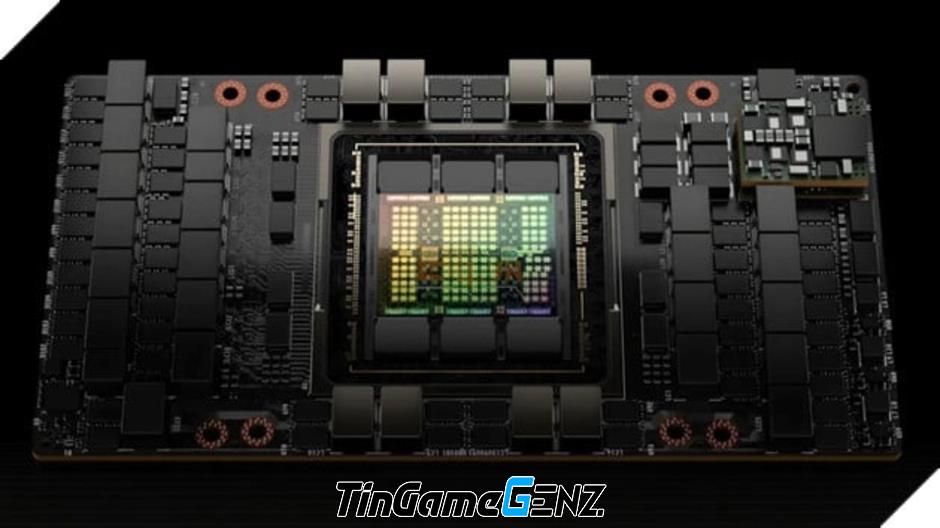

GPU AI H100 của Nvidia đã được bán ra hàng tấn và đang trong tình trạng khan hiếm. Số lượng lớn GPU này được bán ra nhằm phục vụ cho "cuộc cách mạng AI", do đó, mức tiêu thụ điện năng của các GPU này được dự đoán sẽ cao tương đương với mức tiêu thụ điện năng của một thành phố lớn ở Mỹ.

Theo Paul Churnock, một kỹ sư điện phụ trách Chiến lược và quản trị kỹ thuật trung tâm dữ liệu tại Microsoft, tin rằng mỗi GPU H100 có công suất lên đến 700W và dự kiến sẽ tiêu thụ nhiều điện năng hơn tất cả các hộ gia đình ở Phoenix, Arizona vào cuối năm 2024 khi hàng triệu GPU này được triển khai. Tuy nhiên, tổng lượng điện tiêu thụ sẽ ít hơn các thành phố lớn như Houston, Texas.

Theo Churnock, với tỷ lệ sử dụng hàng năm là 61%, GPU H100 tương đương với mức tiêu thụ điện năng của một hộ gia đình trung bình ở Mỹ (2,51 người/hộ gia đình). Dự kiến Nvidia sẽ bán được từ 1,5 đến 2 triệu GPU H100 vào năm 2024. So với mức tiêu thụ điện năng của các thành phố, chip H100 sẽ xếp hạng thứ 5 lớn nhất, sau Houston, Texas và trước Phoenix, Arizona.

Mức tiêu thụ hàng năm là 61%, tương đương GPU H100 sẽ tiêu thụ khoảng 3.740 kilowatt giờ (kWh) điện hàng năm. Giả sử, Nvidia bán 1,5 triệu GPU H100 vào năm 2023 và hai triệu GPU H100 vào năm 2024, thì sẽ có 3,5 triệu bộ xử lý như vậy được triển khai vào cuối năm 2024. Tổng cộng, chúng sẽ tiêu thụ một lượng điện khổng lồ là 13.091.820.000 kilowatt giờ (kWh) mỗi năm, hoặc 13.091,82 GWh.

Để so sánh, lượng điện tiêu thụ hàng năm là 13.091,82 GWh, tương đương với mức tiêu thụ điện hàng năm của một số quốc gia như Georgia, Lithuania hoặc Guatemala.

Trước đó, vào tháng 10, công ty công nghệ Schneider của Pháp đã ước tính rằng tổng mức tiêu thụ điện năng của các trung tâm dữ liệu được sử dụng cho các ứng dụng trí tuệ nhân tạo (AI) ngày nay tương đương với mức tiêu thụ điện của quốc gia Síp.

Trong tương lai, Nvidia sẽ giới thiệu nhiều loại GPU mới như B100 Blackwell, có thể sẽ vượt qua mức tiêu thụ điện năng của H100. Tuy nhiên, các GPU AI sẽ cung cấp hiệu suất cao hơn và hoàn thành nhiều công việc hơn.