Các chuyên gia kỹ thuật Trung Quốc tại Viện Điện toán Thông minh (IIC) của Alibaba vừa sáng tạo ra một ứng dụng AI mới mang tên Emote Portrait Live, giúp biến đổi một bức ảnh tĩnh thành hình ảnh có thể nói và hát.

Công nghệ đằng sau mô hình Emote Portrait Live dựa trên khả năng tổng hợp của các mô hình lan truyền. Mô hình lan truyền là một mô hình toán học được sử dụng để mô tả cách mọi thứ lan truyền hoặc lan rộng theo thời gian. Trong trường hợp này, mô hình lan truyền được áp dụng để mô tả cách các chuyển động trên khuôn mặt truyền từ một điểm xuất phát đến các phần khác của khuôn mặt.

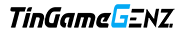

Mô hình Emote Portrait Live sử dụng phương pháp khuếch tán để tổng hợp trực tiếp video đầu nhân vật từ hình ảnh và âm thanh được cung cấp, không cần xử lý phức tạp hay biểu diễn trung gian, giúp đơn giản hóa quá trình tạo video đầu người biết nói.

Mục tiêu của nhóm nghiên cứu là phát triển một khung đầu biết nói có thể nhận diện được nhiều biểu hiện thực tế trên khuôn mặt, bao gồm cả những biểu hiện tinh tế và cho phép chuyển động đầu tự nhiên. Để đạt được mục tiêu này, các nhà nghiên cứu đã tích hợp các cơ chế điều khiển ổn định vào mô hình của họ, bao gồm bộ điều khiển tốc độ và bộ điều khiển vùng mặt, nhằm cải thiện độ ổn định trong quá trình phát triển.

So với các trí tuệ nhân tạo trước đây chỉ có khả năng biến đổi miệng và một phần của khuôn mặt, Emote có thể tạo ra biểu cảm của khuôn mặt, tư thế, nhíu mày hoặc lắc đầu. Đặc biệt, phần miệng được tạo ra bởi trí tuệ nhân tạo trong Emote trông rất tự nhiên.

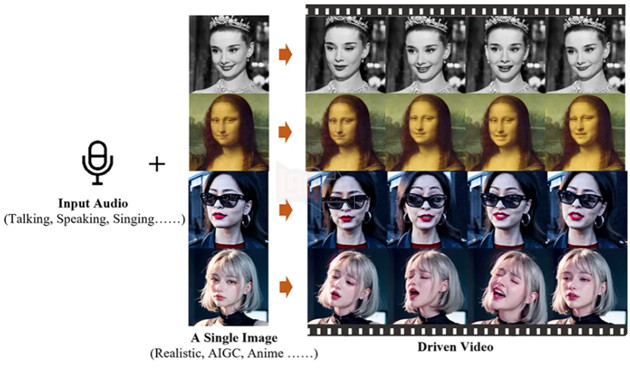

Trong một số video được Alibaba công bố, hình ảnh sẽ chuyển đổi thành video và biểu diễn các bài hát được nhập vào một cách nhanh chóng, giống như việc bức tranh Mona Lisa kể lại đoạn độc thoại của nhân vật Rosalind trong vở kịch As You Like It, Màn 3, Cảnh 2 của Shakespeare.